I statistisk modellering är regressionsanalys en studie som används för att bedöma förhållandet mellan variabler. Denna matematiska metod innehåller många andra metoder för modellering och analys av flera variabler, när fokus ligger på förhållandet mellan den beroende variabeln och en eller flera oberoende. Mer specifikt hjälper regressionsanalys att förstå hur ett typiskt värde på en beroende variabel förändras om en av de oberoende variablerna ändras, medan de andra oberoende variablerna förblir fixerade.

I alla fall är måluppskattningen en funktion av oberoende variabler och kallas regressionsfunktionen. I regressionsanalys är det också av intresse att karakterisera förändringen i den beroende variabeln som en funktion av regression, som kan beskrivas med hjälp av en sannolikhetsfördelning.

Regressanalysuppgifter

Denna statistiska forskningsmetod används i stor utsträckning för prognoser, där dess användning har en betydande fördel, men ibland kan det leda till illusioner eller falska förhållanden, därför rekommenderas det att noggrant använda den i denna fråga, eftersom till exempel korrelation inte innebär ett kausalt samband.

Ett stort antal metoder har utvecklats för att genomföra regressionsanalys, såsom linjär och vanlig minsta kvadratregression, som är parametriska. Deras väsen är att regressionsfunktionen definieras i termer av ett begränsat antal okända parametrar som uppskattas från data. Icke-parametrisk regression tillåter dess funktioner att ligga i en viss uppsättning funktioner, som kan vara oändlig-dimensionell.

Som en statistisk forskningsmetod beror regressionsanalysen i praktiken på formen av dataproduktionsprocessen och hur den hänför sig till regressionsmetoden. Eftersom den verkliga formen av dataprocessen genererar som regel ett okänt nummer beror regressionsanalysen av uppgifterna ofta till viss del på antagandena om denna process. Dessa antaganden verifieras ibland om det finns tillräckligt med tillgängliga data. Regressionsmodeller är ofta användbara även om antaganden bryts moderat, även om de inte kan fungera med maximal effektivitet.

I en smalare bemärkelse kan regression specifikt relatera till bedömningen av kontinuerliga svarvariabler, i motsats till de diskreta svarvariablerna som används i klassificeringen. Fallet med en kontinuerlig utgångsvariabel kallas också metrisk regression för att skilja den från relaterade problem.

Berättelsen

Den tidigaste formen av regression är den välkända metoden med minsta kvadrat. Den publicerades av Legendre 1805 och Gauss 1809. Legendre och Gauss använde metoden för uppgiften att från astronomiska observationer fastställa banor av kroppar runt solen (främst kometer, men senare nyupptäckta mindre planeter). Gauss publicerade en vidareutveckling av teorin om minst kvadrater 1821, inklusive en version av Gauss-Markovs teorem.

Begreppet ”regression” myntades av Francis Galton på 1800-talet för att beskriva ett biologiskt fenomen. Sammanfattningen var att tillväxten av ättlingar från förfädernas tillväxt, som regel, regresserar ner till det normala genomsnittet.För Galton hade regression endast denna biologiska betydelse, men senare fortsatte hans arbete av Udney Yule och Karl Pearson och fördes till ett mer allmänt statistiskt sammanhang. I arbetet med Yule och Pearson betraktas den gemensamma fördelningen av svarsvariabler och förklarande variabler som Gauss. Detta antagande avvisades av Fisher i verk 1922 och 1925. Fisher föreslog att den villkorade fördelningen av svarsvariabeln är gaussisk, men ledfördelningen borde inte vara. I detta avseende ligger Fischers antagande närmare Gauss-formuleringen från 1821. Fram till 1970 tog det ibland upp till 24 timmar att få resultatet av en regressionsanalys.

Regressionsanalysmetoder fortsätter att vara ett område med aktiv forskning. Under de senaste decennierna har nya metoder utvecklats för pålitlig regression; regression som involverar korrelerade svar; regressionsmetoder för olika typer av saknade data; icke-parametrisk regression; Bayesiska regressionsmetoder; regressioner i vilka prediktorvariabler mäts med ett fel; regressioner med fler prediktorer än observationer, såväl som kausala slutsatser med regression.

Regressionsmodeller

Regressionsanalysmodeller inkluderar följande variabler:

- Okända parametrar, betecknade som beta, som kan vara en skalar eller vektor.

- Oberoende variabler, X.

- Beroende variabler, Y.

Inom olika vetenskapsområden där regressionsanalys används används olika termer istället för beroende och oberoende variabler, men i alla fall relaterar regressionsmodellen Y till funktionerna X och β.

Tillnärmningen har vanligtvis formen E (Y | X) = F (X, β). För att utföra en regressionsanalys måste typ av funktion f bestämmas. Mindre vanligt är det baserat på kunskap om förhållandet mellan Y och X som inte förlitar sig på data. Om sådan kunskap inte finns, väljs en flexibel eller bekväm form F.

Beroende Variabel Y

Anta nu att vektorn med okända parametrar ß har längd k. För att utföra en regressionsanalys måste användaren tillhandahålla information om den beroende variabeln Y:

- Om det finns N-datapunkter av formen (Y, X), där N

- Om exakt N = K observeras, och funktionen F är linjär, kan ekvationen Y = F (X, β) lösas exakt och inte ungefär. Detta reducerar till att lösa en uppsättning N-ekvationer med N-okända (element av β), som har en unik lösning så länge X är linjärt oberoende. Om F är icke-linjär kanske lösningen inte existerar eller så kan många lösningar existera.

- Det vanligaste är situationen där N> pekar på data observeras. I det här fallet finns det tillräckligt med information i data för att utvärdera det unika värdet för ß som bäst matchar data, och regressionsmodellen, när den tillämpas på data kan betraktas som ett överbestämt system i ß.

I det senare fallet ger regressionsanalys verktyg för:

- Att hitta lösningar för okända parametrar β, som till exempel minimerar avståndet mellan de uppmätta och förutspådda värdena för Y.

- Under vissa statistiska antaganden använder regressionsanalys överskottsinformation för att ge statistisk information om okända parametrar ß och de förutsagda värdena för den beroende variabeln Y.

Nödvändigt antal oberoende mätningar

Tänk på en regressionsmodell som har tre okända parametrar: β0, β1 och p2. Anta att experimenten utför 10 mätningar i samma värde för den oberoende variabeln av vektorn X.I detta fall ger regressionsanalys inte en unik uppsättning värden. Det bästa du kan göra är att utvärdera medelvärdet och standardavvikelsen för den beroende variabeln Y. Genom att mäta två olika X-värden på samma sätt kan du få tillräckligt med data för en regression med två okända, men inte för tre eller flera okända.

Om experimentets mätningar utfördes vid tre olika värden för den oberoende variabeln av vektorn X, kommer regressionsanalysen att ge en unik uppsättning uppskattningar för tre okända parametrar i p.

När det gäller allmän linjär regression motsvarar ovanstående påstående kravet att matrisen XTX är vändbart.

Statistiska antaganden

När antalet mätningar N är större än antalet okända parametrar k och mätfelet εjagsedan överförs överflödet av information i mätningarna sedan och används för statistiska prognoser angående okända parametrar. Detta överskott av information kallas graden av regressionsfrihet.

Grundläggande antaganden

Klassiska antaganden för regressionsanalys inkluderar:

- Provet är representativt för inferensförutsägelse.

- Felet är en slumpmässig variabel med ett medelvärde på noll, vilket är villkorat av de förklarande variablerna.

- Oberoende variabler mäts utan fel.

- Som oberoende variabler (prediktorer) är de linjärt oberoende, det vill säga att det inte är möjligt att uttrycka någon prediktor i form av en linjär kombination av de andra.

- Fel är okorrelerade, dvs kovariansmatrisen för diagonala fel och varje icke-nollelement är felets varians.

- Felens varians är konstant enligt observationerna (homoskedasticitet). Om inte, kan du använda den viktade minst kvadratmetoden eller andra metoder.

Dessa tillräckliga förutsättningar för uppskattningen av minsta kvadrat har de nödvändiga egenskaperna, i synnerhet innebär dessa antaganden att parameterns uppskattningar kommer att vara objektiva, konsekventa och effektiva, särskilt när de beaktas i klassen av linjära uppskattningar. Det är viktigt att notera att bevis sällan uppfyller villkoren. Det vill säga metoden används även om antagandena inte är sanna. En variation av antaganden kan ibland användas som ett mått på hur användbar denna modell är. Många av dessa antaganden kan mildras med mer avancerade metoder. Statistiska analysrapporter inkluderar vanligtvis analys av tester baserade på provdata och metod för modellverktyg.

Dessutom avser variabler i vissa fall värden som mäts vid punktplatser. Det kan finnas rumsliga trender och rumslig autokorrelation i variabler som strider mot statistiska antaganden. Geografisk viktad regression är den enda metoden som hanterar sådana data.

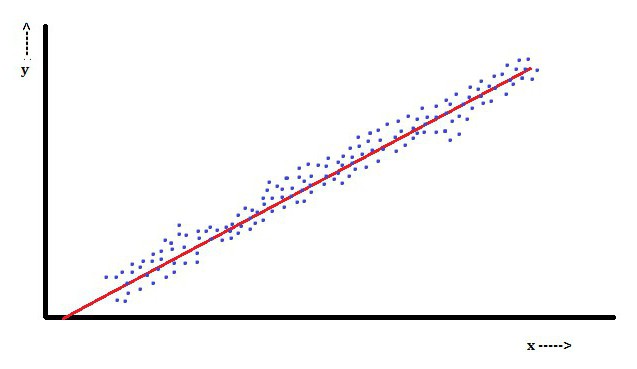

Linjär regressionsanalys

Vid linjär regression är en funktion att den beroende variabeln, som är Yjagär en linjär kombination av parametrar. I en enkel linjär regression används till exempel en oberoende variabel, x, för att modellera n-punkterjagoch två parametrar, p0 och p1.

Med multipel linjär regression finns det flera oberoende variabler eller deras funktioner.

Med en slumpmässig sampling från en population gör dess parametrar det möjligt att få ett exempel på en linjär regressionsmodell.

I denna aspekt är metoden minst kvadrater den mest populära. Med hjälp av detta erhålls parameteruppskattningar som minimerar summan av kvadratrester. Denna typ av minimering (som är karakteristisk för en linjär regression) av denna funktion leder till en uppsättning normala ekvationer och en uppsättning linjära ekvationer med parametrar som löses för att erhålla parameterns uppskattningar.

Under det ytterligare antagandet att befolkningsfelet vanligtvis sprider sig kan forskaren använda dessa uppskattningar av standardfel för att skapa konfidensintervall och testhypoteser om dess parametrar.

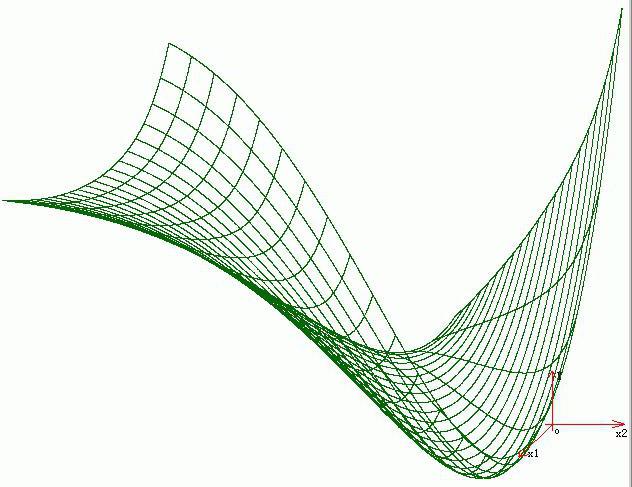

Icke-linjär regressionsanalys

Ett exempel där funktionen inte är linjär med avseende på parametrarna indikerar att summan av rutorna bör minimeras med en iterativ procedur. Detta introducerar många komplikationer som bestämmer skillnaderna mellan linjära och icke-linjära minst kvadratmetoder. Följaktligen är resultaten av regressionsanalys med användning av den olinjära metoden ibland oförutsägbara.

Beräkning av effekt och provstorlek

Här finns det som regel inga konsekventa metoder för antalet observationer jämfört med antalet oberoende variabler i modellen. Den första regeln föreslogs av Good och Hardin och ser ut som N = t ^ n, där N är provstorleken, n är antalet oberoende variabler och t är antalet observationer som krävs för att uppnå önskad noggrannhet om modellen endast hade en oberoende variabel. Till exempel bygger en forskare en linjär regressionsmodell med ett datasätt som innehåller 1000 patienter (N). Om forskaren beslutar att fem observationer behövs för att exakt bestämma linjen (m), är det maximala antalet oberoende variabler som modellen kan stödja 4.

Andra metoder

Trots det faktum att parametrarna för regressionsmodellen vanligtvis uppskattas med den minsta kvadratmetoden finns det andra metoder som används mycket mindre ofta. Till exempel är dessa följande metoder:

- Bayesiska metoder (t.ex. Bayesianska linjära regressionsmetod).

- Procentregression, används för situationer där en minskning i procentfel anses vara mer lämplig.

- De minsta absoluta avvikelserna, som är mer stabila i närvaro av utskott som leder till kvantregression.

- Nonparametrisk regression, som kräver ett stort antal observationer och beräkningar.

- Avståndet för inlärningsmetriket, som studeras på jakt efter ett betydande metriskt avstånd i ett givet inmatningsutrymme

programvara

Alla stora statistiska programvarupaket utförs med användning av regressionsanalys med minsta kvadrat. Enkel linjär regression och multipel regressionsanalys kan användas i vissa kalkylarkapplikationer, liksom på vissa kalkylatorer. Även om många statistiska programvarupaket kan utföra olika typer av icke-parametrisk och pålitlig regression, är dessa metoder mindre standardiserade; olika mjukvarupaket implementerar olika metoder. Specialiserad regressionsprogramvara har utvecklats för användning inom områden som undersökningsanalys och neuroimaging.